Pracuj szybciej z modelami LLM w aplikacji AnythingLLM dzięki kartom NVIDIA GeForce RTX

Uruchamianie dużych modeli językowych (LLM) na lokalnym PC nie jest zarezerwowane wyłącznie dla zaawansowanych użytkowników. Aplikacja AnythingLLM sprawia, że jest to bardzo proste, a teraz dzięki kartom graficznym RTX jest to jeszcze szybsze.

W najnowszym wpisie na blogu RTX AI Garage omówiono w jaki sposób AnythingLLM, aplikacja open-source dedykowana lokalnym zadaniom wykorzystującym sztuczną inteligencję, ułatwia programistom i entuzjastom uruchamianie dużych modeli językowych, systemów RAG i agentów AI bezpośrednio na własnych komputerach, bez konieczności korzystania z chmury i skomplikowanej konfiguracji.

Dzięki dodanemu wsparciu dla mikrousług NVIDIA NIM, AnythingLLM oferuje teraz użytkownikom szybszy i bardziej przejrzysty sposób uruchamiania generatywnych modeli AI. NIM to gotowe kontenery, zoptymalizowane pod kątem kart graficznych RTX, które eliminują potrzebę ręcznego pozyskiwania modeli lub podłączania punktów końcowych. Jest to rozwiązanie plug-and-play na rozpoczęcie pracy z generatywną AI i wyraźny krok w kierunku bardziej dostępnego rozwoju lokalnej sztucznej inteligencji.

Dlaczego ma to znaczenie?

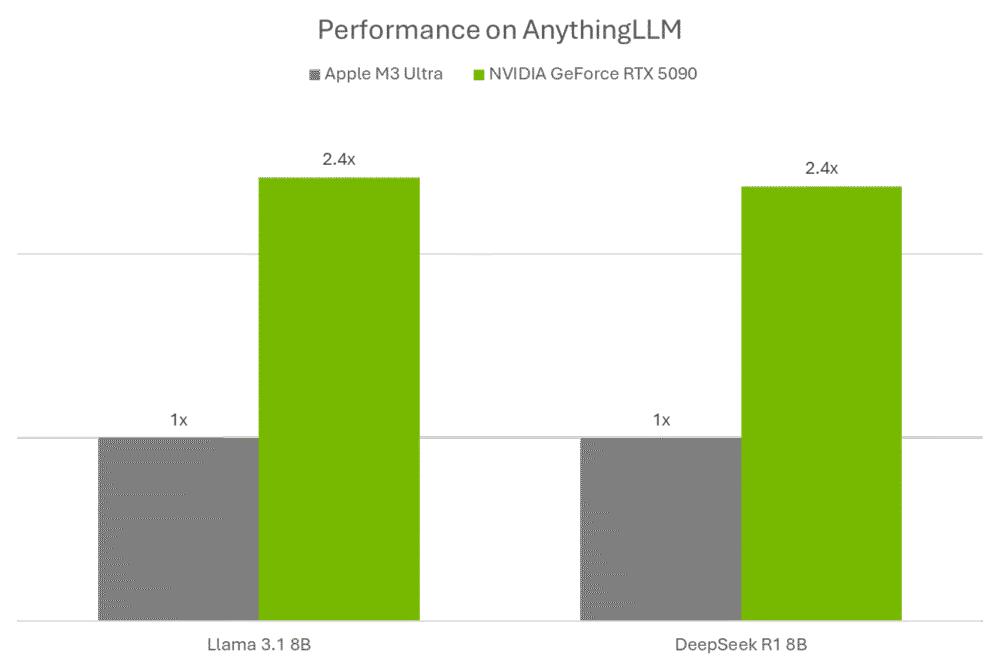

- Szybkość. Wydajność w działaniu LLM na karcie GeForce RTX 5090 jest 2,4 razy większa niż w przypadku układowi Apple M3 Ultra, dzięki przyspieszeniu zapewnianemu przez rdzenie Tensor i pakietowi Ollama + Llama.cpp + GGML.

- Prywatność. Wszystkie dane i modele pozostają lokalne. To duża zaleta dla osób pracujących z treściami zastrzeżonymi, osobistymi plikami lub prywatnymi procesami.

- Prostota. AnythingLLM oferuje przejrzysty interfejs użytkownika i instalację za pomocą jednego kliknięcia. W połączeniu z mikrousługami NIM eliminuje typowe obciążenia związane z pracą z modelami LLM.

W artykule omówiono również, w jaki sposób użytkownicy łączą AnythingLLM z rosnącym zestawem szablonów AI (Blueprints) firmy NVIDIA w celu rozszerzenia i prototypowania multimodalnych działań, od chatbotów po analizę danych i automatyzację agentów AI. Wszystko na lokalnym PC z kartą RTX.